OS:Windows7

IntelliJ:15.0.6

今回行う事は大きく2つです。

1. Windows上へのGoのインストール

2. IntelliJ側のプラグインのインストールと設定

では早速Goのインストールから始めようと思います。

Go SDKのインストール

- 下記のサイトからGoのインストーラー「go1.6.2.windows-amd64.msi」をダウンロードしてきます。

https://golang.org/dl/ - インストーラーを起動し、インストールを開始します。

インストーラーはデフォルトだとインストール先がC:\Goになっているので、

別のディレクトリに入れたい場合は、任意のディレクトリを指定して下さい。 - インストールが完了したら、コマンドプロンプトを起動し、goのバージョンを確認します。

> go version

バージョンの確認が出来たらプロンプトは閉じても問題ありません。

※この時点でPathやGOROOT等の環境変数は自動で設定されています。

では引き続きIntelliJ側の設定を行っていきます。

IntelliJのPluginインストール

- IntelliJを起動します。

- 「Welcome to IntelliJ IDEA」の画面右下の「configure」→「Plugins」をクリック

- 画面下側の「Browse repositories…」をクリック。

- 画面上部の検索窓に「GO」と入力し、「GO」と書いてあるものをインストールします。

- プラグインのインストールが完了すると、再起動を求められるので、IntelliJを再起動します。

- 再起動したら、「Welcome to IntelliJ IDEA」画面で「Create New Project」をクリック。

- 画面左側のリストにGoがあるので、GoをクリックしてNextをクリック

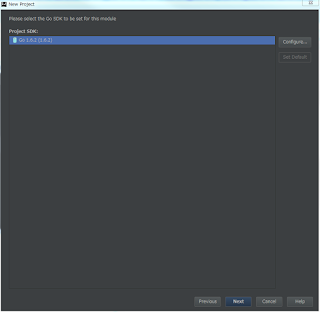

- Procjet SDKの画面で「Configure...」をクリック

- Goをインストールしたディレクトリを指定し、OKを押下、Project SDKにGoと出てれば、Nextボタンを押下する。

(Go言語をインストール時に何も変更指定なければ、C:\Goにインストールされているので、そのままOKを押せば問題ない)

- Procjet NameとProject locationを任意の場所にしてFinishをクリック

- 開いたプロジェクトでGo Fileを追加して、Hello World的なのを書いてみる。

package main import "fmt" func main(){ fmt.Printf("Hello World!") } - 書いたら実行(メニューバーのRun -> Run ‘go run XXXXX.go’)

- コンソールにHello World!と出れば成功!

基本的にはGoをインストールとIntelliJの画面内の操作で完結するようです。

おまけ

最初はIntelliJのバージョンが15.0.4のものを使っていたのですが、なぜかGo SDKのディレクトリを指定しても、下記の様なエラーが出てしまって使えませんでした。

「The Selected directory is not a valid home for Go SDK」

IntelliJのバージョンと、Pluginのバージョンが合っていないのかとも思ったのですが、

PluginのREADMEを確認する限りでは問題ありませんでした。

go-lang-idea-plugin

取り敢えずIntelliJの最新バージョンが出てたのでアップデートしてみたら使えるようにはなったのですが、

これで根本原因が解決出来たのかは不明です・・・。